从GANs到扩散模型到自回归模型

扩散模型胜过 GAN 的原因

- 更易于缩放和训练:与 GAN 相比,扩散模型通常更容易缩放和训练。这是因为 GAN 存在臭名昭著的训练不稳定性,并且可能难以捕获数据分布的全部多样性。

- 更好的分布覆盖率:扩散模型能够更好地覆盖数据分布,从而产生更多样化的样本。GAN 通常会牺牲多样性来换取保真度,从而导致样本质量高但无法涵盖整个分布。

- 静态训练目标:扩散模型具有静态训练目标,这使得它们更容易优化。另一方面,GAN 具有对抗性训练目标,这可能导致训练动态不稳定。

自回归模型胜过扩散模型的原因

- 与大型语言模型 (LLM) 的范式一致:自回归模型与 LLM 使用相同的“下一个标记预测”范式。这使得使用 LLM 的进步来改进自回归图像生成模型成为可能。

- 潜在的统一语言和视觉模型:自回归方法有可能在语言和视觉之间建立统一的模型。扩散模型具有与自回归语言模型不同的范式,这给建立语言和视觉的统一模型带来了巨大的挑战。

- 利用 LLM 框架的优势:自回归模型可以利用 LLM 社区开发的技术来优化训练方法和推理速度。

三种模型的核心思想、模型架构和主要进展

生成对抗网络 (GAN)

- 核心思想:GAN 由两个神经网络组成:生成器和判别器。生成器学习从随机噪声中生成数据,而判别器学习区分生成数据和真实数据。两个网络在对抗性过程中一起训练,生成器试图欺骗判别器,而判别器试图正确地对数据进行分类。

- 模型架构:GAN 的架构可以根据具体应用而变化。生成器通常采用反卷积网络,而判别器通常采用卷积网络。

- 损失函数:生成对抗网络 (GAN): GAN 的核心损失函数是对抗性损失。对抗性损失是基于判别器的输出计算的。判别器的目标是正确区分真实数据和生成数据。生成器的目标是生成能够欺骗判别器的数据。因此,对抗性损失函数的设计是为了最大化判别器在真实数据上的输出,同时最小化判别器在生成数据上的输出。

- 主要进展:近年来,GAN 取得了许多进展,包括渐进式生长、风格化 GAN 和 BigGAN。这些进展提高了 GAN 生成的样本的质量和多样性。

扩散模型

- 核心思想:扩散模型通过逆转一个逐渐加噪的过程来从分布中采样。该模型通过逐步从信号中去除噪声来生成样本,其训练目标可以表示为重新加权的变分下界。

- 模型架构:扩散模型通常使用 UNet 架构,该架构由一系列残差层和下采样卷积组成,然后是一系列具有上采样卷积的残差层,跳过连接连接具有相同空间大小的层。

- 损失函数:扩散模型的核心损失函数是去噪分数匹配 (DSM) 或均方误差 (MSE) 损失。DSM 损失函数是基于模型在不同噪声水平下预测数据分数的准确性计算的。 MSE 损失函数用于训练模型预测噪声图像中的噪声分量。 两种方法都旨在训练模型逐步去除噪声并生成高质量样本。

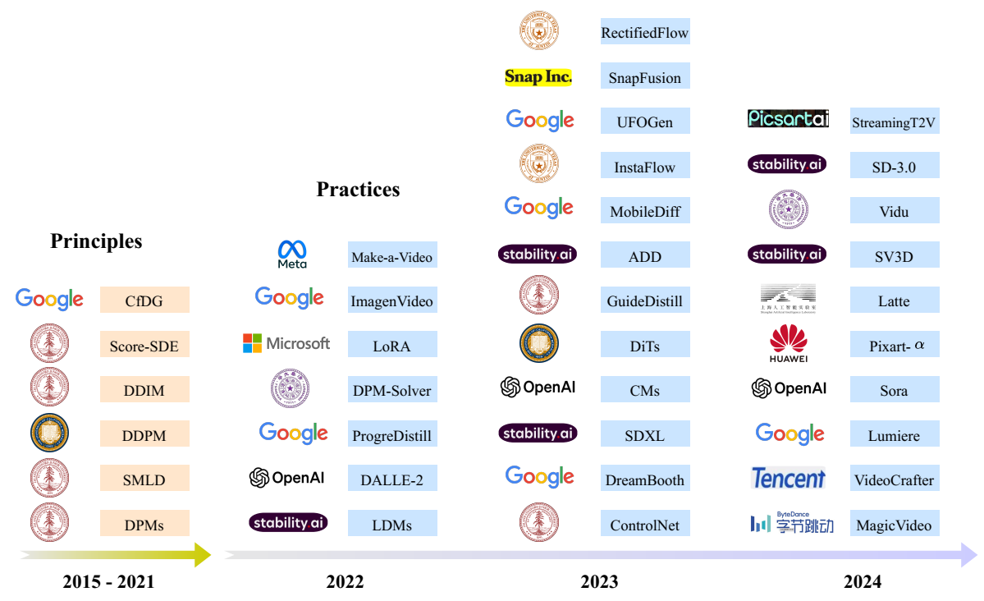

- 主要进展:扩散模型的最新进展包括改进的 UNet 架构、分类器引导 和上采样扩散模型。这些进展提高了扩散模型生成的样本的质量和效率。

自回归模型

- 核心思想:自回归模型通过预测序列中的下一个标记来生成数据。在图像生成中,图像首先被标记化,然后自回归模型逐个标记地生成图像标记。

- 模型架构:自回归图像生成模型通常使用类似于 LLM 的架构,例如 Llama。

- 损失函数:自回归模型的核心损失函数是交叉熵损失。交叉熵损失函数用于衡量模型预测的概率分布与真实数据分布之间的差异。在自回归图像生成中,该损失函数用于衡量模型预测的下一个图像标记的概率分布与真实下一个图像标记的概率分布之间的差异。

- 主要进展:自回归图像生成模型的最新进展包括改进的图像标记器、可扩展图像生成模型 和使用 LLM 训练技术。这些进展提高了自回归模型生成的样本的质量和效率。

不同的模型架构,例如 GAN 中的生成器和判别器网络结构、扩散模型中 UNet 的深度和宽度、自回归模型中 Transformer 的层数和注意力头数,都会影响模型的参数量和大小。GAN 的大小可以变化很大,从几百万个参数到数十亿个参数不等。这取决于具体的 GAN 架构和应用。扩散模型通常比 GAN 大,参数量从数百万到数十亿不等。近年来,一些大型扩散模型的参数量已经超过了百亿。自回归模型的规模也可能很大,尤其是用于图像生成的模型。一些基于 Transformer 的自回归模型的参数量也已经超过了百亿。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Model The World!